Deep Learning 專項課程是史丹佛的吳恩達教授,用他創業的 deeplearning.ai 公司的名義開設的系列課程,

Neural Networks and Deep Learning 是專項課程中的第一門,主要是在介紹Neural Network 「類神經網路」的架構給大家認識。

第一週的主要內容是在帶大家入門,介紹 AI 即將帶來的變革,

吳恩達教授把AI 形容為有如電力一般的變革性技術,將會為無數的產業帶來巨大的轉變,

而這一系列課程就是要引領大家入門。

本系列的第一堂課是在為大家介紹 Neural Netowork 和 Deep Learning 的大略架構,

第二堂課會介紹 hyperparameter (超參數) 的調整和演算法的優化,

第三堂課傳授如何執行 ML專案,第四/五堂課則分別會介紹常用於圖像處理的CNN和自然語言處理的RNN系列演算法。

要提到Neural Network 「類神經網路」 之前,要先介紹組成NN 的基本元素: neuron (神經元),

簡單來說,神經元就是在知道我們告訴他的輸入 (input, X) 以及輸出 (output, Y)之後,為X/Y建立起關係,

以常見的房價預測案例來說,我們的輸入可能就是房子的大小,而輸出是房子的價格,

藏在神經元裡面的,通常是一個函數,例如 ReLU (rectified linear unit)。

不過我們都知道,要預測房價不可能就只有一個因素,必然是多個因素的結合,因此單個神經元勢必無法有效解決,

此時直覺的解決辦法就是把多個神經元堆疊在一起,當我們餵進去夠多的資料讓神經元自己去建立輸入/輸出之間的連結,

我們就能建成一個能有效預測房價的類神經網路 neural network 模型。

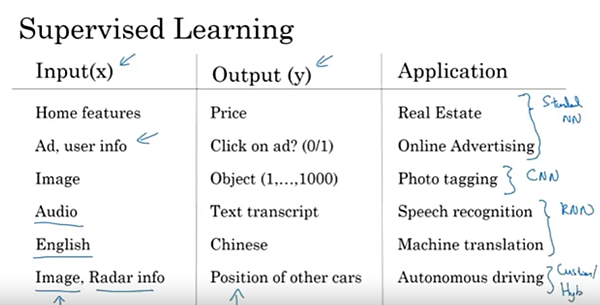

像這一種輸入/輸出都已經明確標記出來的情境,我們稱之為「監督式學習」 Supervised Learning,

大多數的機器學習專案,基本上是使用Supervised Learning ,Supervised Learning 可以應用的場景非常廣泛,

例如預測房屋價格、提升廣告點擊率、標記照片內容、轉譯音源檔、語言翻譯、自動駕駛等等,

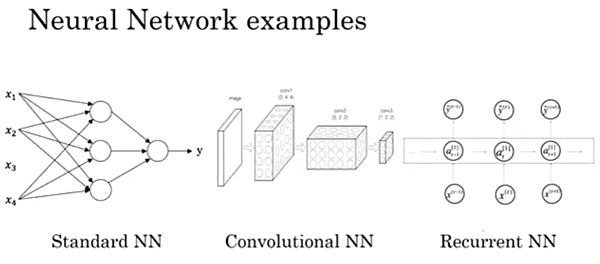

其中,預測價格和點擊率提升都是使用常規的Neural Network,

圖像相關的應用則會使用 Convolutional Neural Network (CNN),

而語言相關的應用則會使用 Recurrent Neural Network (RNN),

原因在於我們說出的話由於是一個接一個的文字產生的,因此是天然的一維時間序列。

這三種主流的深度學習手法,可以用下面這張圖來概括:

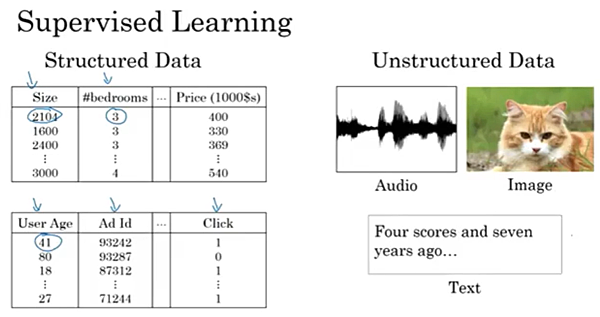

接下來提到兩種我們在做監督式學習的資料型態,分別是結構式/非結構式資料,

其實兩者的差異很簡單,結構式資料就是像房價、房屋資訊這種有明確的對應關係的資料,

而非結構性資料則是像圖像或語言這種還需要分析歸納才能有效辨視出來的資料,

一直以來,結構性的資料對於電腦程式來說都是很好理解的,但相對而言,非結構性資料對電腦來說就非常困難,

因為幾乎不可能訂立出一個明確的規則去很好地分析這種資料,

但是人類反而非常能理解非結構性資料,

因為這些就是我們日常生活中的種種場景,是我們活了數十年在腦中建立起來的能力,

而深度學習在近年來能如此激勵人時,正是因為在深度學習的幫助下,電腦終於能在這部分開始超越人類能達到的水準。

本週最後介紹為何深度學習得以掘起。

熟悉相關歷史的人便知道,Deep Neural Network 事實上是在上個世紀就存在的,但是三十年以來卻未能得以普及,

但是除了演算法本身的革新,例如從S型函數 (sigmoid) 進展到 ReLU 以外,

還有兩大推手 (1) 數位化帶來的大數據 (2) 演算速度的革新

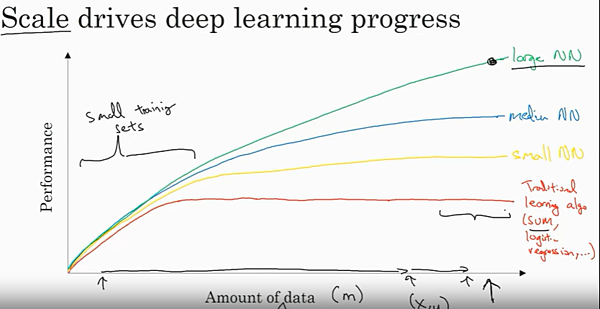

以上圖為例,

比較簡單的機器學習演算法,例如支援向量機 (support vector machine),

在資料量相對較少時,表現能隨資料的增加而進步,但很快就進入高原期,

相較來說,類神經網路由於有更多的參數,因此能在大量的資料 (因而有更複雜的因果關係)時,有效分析並有更好的預測能力,

而隨著我們把類神經網路加深,對應大數據的能力就會越好。

換言之,越深的Neural Network 就有越高的表現上限,而下限也不會比簡單的演算法差,

因此隨著數位化讓我們更容易收到各種資料,類神經網路自然而然成為這年代首選的演算法,

但是隨之而來的便是運算速度的問題:

即便類神經網路表現得再好,如果我們得花數個月的時間才能建成一個模型 (而這是早期很常發生的),

那根本就無法推動Deep Learning 的進展,

所幸近幾十年來,

以英特爾/台積電為首的半導體製造商,不斷推展製程技術,同時英偉達Nvidia 帶來的GPU 革新,帶來深度學習所需的大量算力,

讓深度學習的技術能快速被驗證與突破。

因此,吳恩達教授在最後表達於 Deep Learning 的未來的樂觀想法,

隨著數位化持續地推展、網路硬體和CPU/GPU 不斷地進步,深度學習的發展勢必無可限量。

留言列表

留言列表